大規模言語モデル(LLM)を搭載した生成AIアプリケーションは、さまざまな業界において多大な可能性を秘めています。しかし、このような強力なモデルを構築、デプロイ、監視するのは複雑な作業です。そこで、NVIDIAとNew Relicの協力によって、AIを活用したエンタープライズアプリケーションの本番環境での構築、デプロイ、監視を効率的に行うことを可能にしました。

NVIDIA NIMは、NVIDIA AI Enterpriseに含まれており、各種モデルを最適化されたコンテナとして提供するクラウドネイティブなマイクロサービスのセットです。これらのコンテナは、クラウド、データセンター、ワークステーション上でデプロイでき、Copilotやチャットボットをはじめとする生成AIアプリケーションを簡単に作成することができます。

New Relic AI Monitoringは、シームレスにNVIDIA NIMと統合し、MetaのLlama 3、Mistral Large、Mixtral 8x22Bなど、NIMによってサポートされる幅広いAIモデルを活用して構築されたアプリケーションに対してフルスタックオブザーバビリティを提供します。この統合により、組織はNVIDIA NIMで構築されたAIアプリを安心してデプロイ、監視し、市場投入までの時間を削減してROIを向上させることが可能になります。

NVIDIA NIMとは?

NVIDIA NIMは推論マイクロサービスのセットです。データセンターやクラウドで、NVIDIAの高速インフラストラクチャ全体のデプロイメントを簡素化する、ビルド済みの最適化されたLLMモデルを提供します。これにより企業は、さまざまなインフラストラクチャ上で実行できるようにモデルを最適化したり、開発者がアプリケーションを構築するためのAPIを作成したり、本番環境でこれらのモデルのセキュリティとサポートを維持したりするために貴重な時間とリソースを費やす必要がなくなります。NIMは生成AIの課題に次のように対処します。

- ビルド済みの最適化されたモデル:NIMでは、あらかじめトレーニングされたLLMモデルのライブラリを提供し、モデル開発に必要な労力と専門性を軽減します。これらのモデルは、特にNVIDIA GPU用に最適化されているため、効率的なパフォーマンスを確保できます。

- 簡単なデプロイ:NIMは、コンテナ化されたマイクロサービスを利用しているため、簡単にデプロイすることができます。コンテナにはLLMモデルを利用するために必要なものがすべて含まれているため、クラウド環境からオンプレミスのデータセンターまで、さまざまなプラットフォーム上で迅速かつ簡単なデプロイが可能になります。

- セキュリティの強化:強力なセキュリティが必要なアプリケーションには、NIMのセルフホスト型モデルデプロイメントのオプションを利用することで、完全にデータを管理することができます。

始めてみよう

New Relic AI Monitoringは、NVIDIA NIMで構築されたアプリケーションのAIスタック全体について、オブザーバビリティ機能を提供します。データのプライバシーとセキュリティを確保しながら、労力をかけずに監視、デバッグを行い、AIアプリケーションのパフォーマンス、品質、コストを最適化することができます。NVIDIA NIMで構築されたAIアプリケーションの監視を開始する手順について、ステップごとにご紹介します。

ステップ1:NVIDIA NIMで構築されたAIアプリケーションを計装する

始めに、アプリケーションの計装設定をします。以下がその方法です。

- 無料のNew Relicアカウントに登録するか、すでにアカウントをお持ちの場合はログインします。

- Add Dataをクリックします。

- 検索バーにNVIDIAと入力し、NVIDIA NIMを選択します。

- アプリケーションのプログラミング言語を選択してください(Python、Node.js)。

- ガイダンスにしたがってセットアップのプロセスを進めてください。この例では、NVIDIA NIMで構築されたAIアプリケーションの計装について説明します。サンプルのアプリ名は「local-nim」です。

ステップ2:AI Monitoringにアクセスする

アプリケーションを計装すると、AI Monitoringを使用できるようになります。

- New RelicのダッシュボードでAll Capabilitiesに移動します。

- AI Monitoringをクリックします。

- AI MonitoringセクションのAll Entities内に、NVIDIA NIMで構築したサンプルアプリ「local-nim」が表示されます。

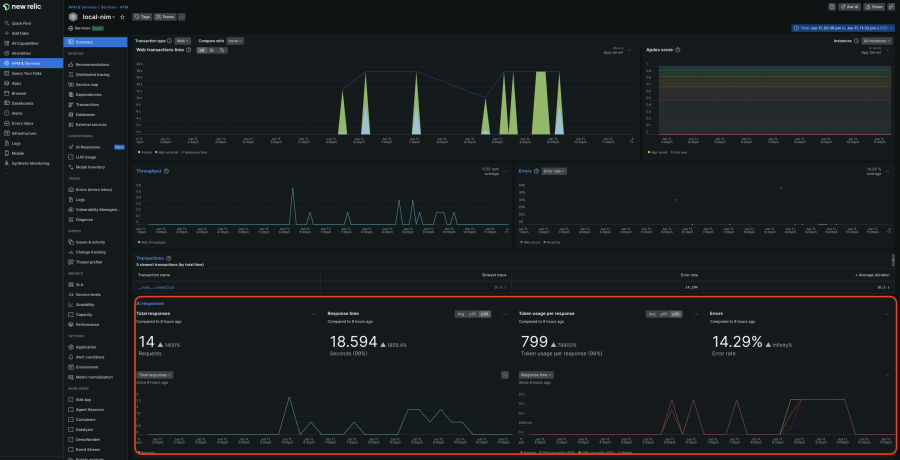

- 「local-nim」というアプリケーションをクリックして、APMのSummary画面を開きます。この統合的なビューにより、NVIDIA NIMを使ったAIアプリケーションに対する合計リクエスト数、平均応答時間、トークンの使用状況、応答エラー率など、AIレイヤーの主要なメトリクスに対するインサイトを瞬時に把握できます。これらの結果は、APMゴールデンシグナル、インフラストラクチャインサイト、ログとともにコンテキスト内に表示されます。すべての情報を1か所で相関させることで、問題の原因をすばやく特定し、さらに掘り下げて詳細に分析することができます。

ステップ3:トレーシングを使ってAIアプリケーションのレスポンスを深く分析する

より詳細な分析には、トレーシング詳細ビューがとても便利です。

- APMのメニューで、左側にあるAI Responsesナビゲーションをクリックし、詳しく掘り下げたいレスポンスを選択します。

- このビューでは、最初のユーザー入力から最終的な応答まで、トークン数やモデルの情報、実際のユーザーインタラクションなど、一連の処理全体を確認することができます。これにより、問題の原因をすばやく特定することが可能です。

ステップ4:Model Inventoryを活用する

Model Inventoryでは、すべてのサービスとアカウントにおけるモデルの使用状況を包括的に表示します。これにより、あらゆるモデル関連のパフォーマンス、エラー、コストの問題を切り分けることができます。

- AI Monitoringセクションに戻ります。

- Model Inventoryをクリックして、モデルのパフォーマンス、エラー、コストメトリクスを確認します。

ステップ5:モデルを比較して最適な選択をする

コストとパフォーマンスのニーズに最適なモデルを選択します。

- Compare Modelsをクリックします。

- ドロップダウンリストから、比較したいモデル、サービス、時間範囲を選択します。

ステップ6:プライバシーとセキュリティを強化する

NVIDIA NIMのセルフホスト型モデルが備える強力なセキュリティの利点を補完するため、New RelicではAIのリクエストとレスポンスから機密データ(PII)の監視を除外することができます。

- Drop Filters をクリックし、 表示されるイベントにおいてどのデータを除外の対象にするか設定します。

NVIDIAとNew Relicにより、本番環境へのAI導入を加速

NVIDIA NIMとNew Relic AI Monitoringは、本番環境へのAI導入の迅速化を求める組織に、魅力的なソリューションを提供します。ビルド済みのモデル、効率化されたデプロイ、包括的な監視を活用することで、企業はパフォーマンスの高い生成AIアプリケーションを迅速に提供することができるため、大幅なコスト削減と早期の投資収益化が実現します。このコラボレーションは、AIとその革新的な可能性を誰もが利用できるような環境に向けた大きな一歩となります。

無料のNew Relicアカウントに登録して、今すぐNVIDIA NIMアプリケーションの監視を始めましょう。

本ブログに掲載されている見解は著者に所属するものであり、必ずしも New Relic 株式会社の公式見解であるわけではありません。また、本ブログには、外部サイトにアクセスするリンクが含まれる場合があります。それらリンク先の内容について、New Relic がいかなる保証も提供することはありません。